Du contenu roi aux données reines

Les données sont le nouvel or numérique, aux enjeux considérables. Dans ce contexte, les moteurs de recherche, et en particulier Google, cherchent à se positionner sur le terrain de leur monétisation.

Souvenez-vous… il y a quelques années, le contenu était considéré comme la matière première du web : celui qui maîtrisait le contenu maîtrisait le web (les portails qui agrégeaient de très nombreuses sources de contenu concentraient également l’audience). Puis, il y a eu MySpace, les Skyblogs, Facebook, Twitter, Foursquare… et maintenant il paraît que c’est la communauté qui est reine. Certes, les plateformes sociales sont indéniablement en haut des tableaux d’audience, mais je reste convaincu que, sans contenus, une communauté n’est pas viable. Comprenez par là que ce sont les contenus qui alimentent les conversations et font tourner les communautés. De ce point de vue là, les plateformes sociales ne sont qu’un intermédiaire entre le contenu et les internautes. Un intermédiaire à valeur ajoutée, mais qui présente tout de même une certaine fragilité dans sa pérennisation (cf. De la qualité des contenus sur Facebook).

Sans rentrer dans la polémique, je pense ne pas me tromper en disant que le contenu reste roi, la communauté se nourrit de ce contenu pour générer des interactions sociales (mais là encore il y a des subtilités : ne confondez plus communautaire et social). La grande question que je me pose est la suivante : qu’est-ce qui alimente les rédacteurs de ce contenu ? C’est là où les données entrent en scène ; non pas les données que les rédacteurs possèdent déjà, mais plutôt les données disponibles publiquement que les internautes peuvent interroger et manipuler à loisir.

Les données à la base du… journalisme de données

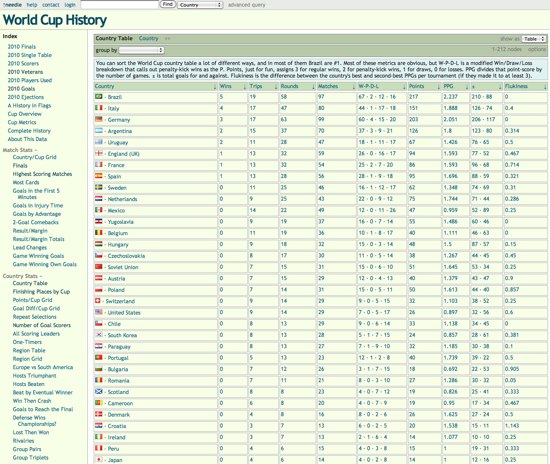

Nous parlons bien ici de données brutes en très grande quantité (des chiffres) qu’il serait trop coûteux de traiter. En les exposant publiquement, ce travail de compilation/trituration/interprétation est délégué à la communauté qui va ainsi pouvoir nourrir une réflexion ou appuyer des prises de position. Et à ce petit jeu, certains journalistes en ont fait leur spécialité, cela s’appelle du journalisme de données (datajournalism en anglais). L’idée est d’extraire des informations pertinentes de quantités importantes de données.

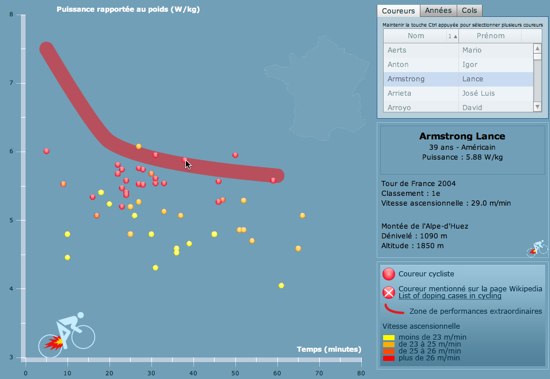

Pour vous aider à comprendre l’intérêt de cette pratique, amusez-vous à compter le nombre d’articles qui font référence à Google Trends, les statistiques de recherche sont les données sur lesquelles repose toute l’argumentation de ces articles. Autre illustration avec ce graphique très intéressant qui met en évidence les performances extraordinaires (=suspectes) des coureurs du Tour de France.

Analyse des performances extraordinaires des coureurs du Tour de France

Ces données sont extraites du portail ActuVisu qui permet justement de manipuler des bases de données (cf. Datajournalisme : du nouveau en France avec ActuVisu). Les données sont, dans ce cas de figure, la matière première d’une réflexion, ou plutôt d’une investigation. Les possibilités sont nombreuses et la profession se met en marche pour développer de nouvelles compétences dans ce domaine. Pour mieux comprendre ce phénomène, je vous recommande les trois articles suivants : pourquoi le data-journalisme, c’est l’avenir en marche, Quatre voies du datajournalism et Illusions et malentendus sur le journalisme de données.

Après les portails de contenus, les portails de données

L’exemple français d’ActuVisu illustre une tendance de fond initiée il y a cinq ans avec la fondation Gapminder qui fournit justement un accès à de très nombreuses données et statistiques (leur credo : “Unveiling the beauty of statistics for a fact based world view“).

Mieux comprendre le monde avec Gapminder

Tout l’intérêt de ce portail est d’une part d’agréger le plus grand nombre de données possible (de préférence en les rendant exploitables et compatibles) ainsi que de fournir un outil simple pour manipuler et visualiser ces données. Il existe d’autres initiatives comme Many Eyes d’IBM, Socrata, ou, plus modestement, Worldmapper. Notez que ces interfaces pour données sont une notion chère à Tim Bernes-Lee (cf. ReadWriteWeb Interview with Tim Berners-Lee, part 2 : search engines, user interfaces for data, Wolfram Alpha, and more…), preuve que ce sujet est important.

Un créneau très porteur qui intéresse les moteurs de recherche de Google, qui a racheté en 2007 l’outil de visualisation qui propulse Gapminder et qui propose également Google public data explorer dans son labo. Ce rachat fait sens dans la mesure où Google est très certainement un des mieux placé pour collecter les données éparpillées aux quatre coins du web. Reste encore le problème des données non-publiques.

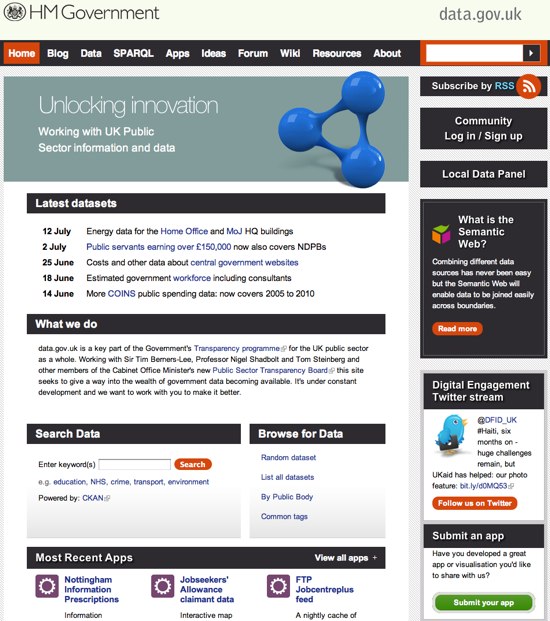

Libération des données publiques avec Open Data

Les initiatives d’Open Data consiste à libéraliser les données publiques pour apporter plus de transparence (à l’image du portail anglais WhereDoesMyMoneyGo?) et pour nourrir des réflexions et projets sociétaux (lire à ce sujet Open Data : des licences libres pour concilier innovation sociale et économique). L’administration américaine a été la première à se lancer en ouvrant le portail Data.gov, suivie par d’autres pays comme l’Angleterre, l’Australie et la Nouvelle-Zélande (cf. Quel modèle pour le data.gov français ?).

Le portail des données publiques anglaises Data.gov.uk

Il est important de comprendre que ces initiatives ne sont pas tant une manœuvre politique ou un outil de surveillance qu’un levier d’innovation pour accélérer l’émergence de nouveaux modèles sociétaux ou de nouveaux projets relatifs à l’environnement, l’éducation, la santé…

Pour le moment le chantier est toujours en cours en France mais des initiatives locales permettent déjà d’accéder à des poches de données : État des lieux de l’OpenData en France.

Les données comme trésor de guerre des moteurs

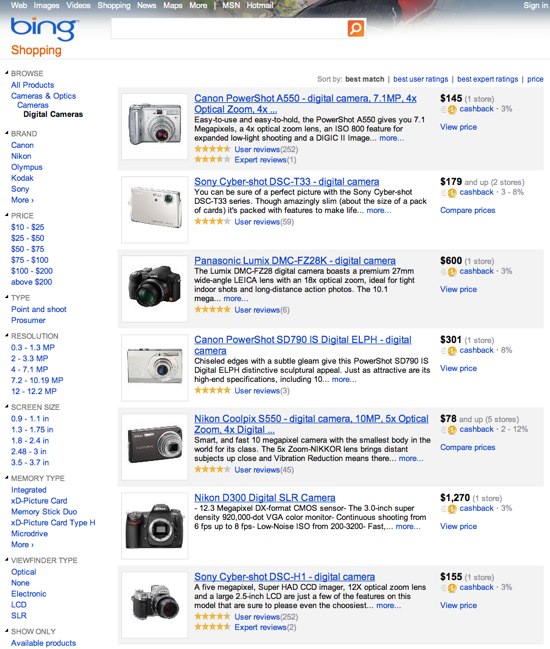

Comme nous venons de le voir, les données sont donc une matière première particulièrement convoitée. À partir de ce constat, il n’est pas surprenant de voir que les grands moteurs de recherche s’intéressent de près à ces données et cherchent à les exploiter pour apporter une couche d’intelligence aux résultats de recherche. Illustration avec le tout nouveau Bing Shopping qui propose des pages de résultats structurées.

Les résultats de recherche structurés de Bing Shopping

L’idée derrière tout ça est de proposer non pas un moteur de recherche, mais un outil d’aide à la décision (cf. New version of Bing Shopping). Et pour structurer des résultats, que faut-il ? Des données ! Autant Microsoft a opté pour des partenariats, autant Google est passé à la vitesse supérieure avec notamment l’acquisition d’ITA, un fournisseur de données touristiques spécialisé sur l’aérien qui va permettre à Google de faire de l’intégration verticale sur ce créneau : With ITA purchase, Google now owns the skies.

La vente de billets d’avion en ligne est un business très juteux, il est donc normal que Google casse sa tirelire pour blinder sa position. Il y a par contre des secteurs à priori moins rémunérateurs mais pour lesquels un outil de consolidation/manipulation /visualisation des données offrirait une position dominante à son éditeur : l’immobilier, l’emploi, les loisirs (IMDB est un bon exemple de données structurées à valeur ajoutée) ou encore le sport (citons l’exemple de Footbalistic). Je vous recommande à ce sujet l’article de GigaOm qui détaille ces exemples : Who will Google buy next for structured data ?

L’idée ici est d’investir dans une base de donnée verticale et de monétiser son exploitation. Constituer une base de données de référence est un chantier titanesque, et seuls les acteurs avec les plus gros moyens peuvent y parvenir. Mais une fois le monopole établi, les possibilités sont nombreuses pour rentabiliser cet investissement. Google Maps est un autre exemple intéressant d’une gigantesque base de données (géographiques) dont nous avons maintenant beaucoup de mal à nous passer et dont le propriétaire a tout le temps pour trouver des solutions de monétisation viables.

Plus intéressant, un article de GigaOm nous révèle que ITA ne se restreint pas au secteur du tourisme aérien mais édite également une solution de manipulation de données accessible sur Needlebase.com : Meet the web database company Google just bought. Cette solution ne permet pas de manipuler des données publiques mais de groupes de données dont l’utilisateur a les droits. Toujours est-il que cette solution est à la fois puissante et intuitive, tout ce dont nous avons besoin pour faire du journalisme de données.

-

Manipulation de données avec Needlebase

Tout récemment, Google a fait une acquisition qui va dans ce sens, en mettant la main sur Metaweb, une gigantesque base de donnée “ouverte” où sont répertoriés douze million d’entités sémantiques (visibles sur Freebase.com) : Google acquires ‘open database’ company Metaweb to enrich search results.

Vers des systèmes auto-alimentants

Voici donc la stratégie de Google : acheter des données avec l’idée de la monétiser une fois que le marché sera devenu dépendant de leur exploitation. Mais sommes-nous réellement dépendant des données ? Vous particulièrement, probablement pas, mais de nombreux aspects de votre quotidien reposent sur une exploitation fine de données. Nous pourrions même aller plus loin en disant que l’exploitation des bonnes données pourrait améliorer votre quotidien (cf. Nos vies gérées par les données) ou la productivité d’une entreprise.

Les objets de notre quotidien pourraient ainsi capter un grand nombre de données vous concernant et fournir ainsi des statistiques très précieuses sur votre mode de vie et la façon d’optimiser votre alimentation, vos trajets, votre budget, votre suivi médical… Imaginez alors l’intérêt d’un coach qui serait à même d’interpréter ces données et de vous offrir de précieux conseils pour améliorer votre quotidien. Ces conseils, et les données qui en sont à l’origine deviendraient rapidement une drogue pour des hommes et des femmes soucieux de leur bien-être : The upcoming Internet pandemic : data addiction.

Reste encore à régler le problème de la collecte : seule une minuscule minorité des habitants de cette planète serait d’accord pour s’équiper des outils de mesure de son quotidien (sommeil, alimentation, exercices physiques, trajets, dépenses…). Une minorité de geeks, sauf si un acteur industriel avec de gros moyens décide de fournir gratuitement les outils de mesure et de collecte en faisant un pari sur l’avenir (et sur la monétisation de ces données). Et cet industriel avide de données, encore une fois c’est Google avec son projet de compteur intelligent PowerMeter.

Suivi de votre consommation quotidienne avec Google PowerMeter

Et même si Google ne peut pas remplacer tous les compteurs électriques des pays occidentaux, il peut fournir la plateforme pour consolider les données et les re-publier : Google releases API for energy tool PowerMeter. La promesse de Google est simple : vous aider à mieux comprendre vos habitudes de consommation pour optimiser vos dépenses… Tout en revendant les statistiques aux industriels pour qu’ils puissent développer des appareils ménagers plus en phase avec le mode de vie de leurs clients.

Loin de moi l’idée de jouer les paranoïaques et de dénoncer ces pratiques, car si tout le monde y trouve son intérêt il n’y a pas de raison de s’en priver. Il n’empêche que si je fais la somme de tout ce que Google peut potentiellement savoir sur moi, ça commence à faire beaucoup :

- Mes contacts avec Gmail ou Android (carnet d’adresse + historique des appels) ;

- Mon profil (âge, parcours…) avec Google Me ;

- Mes achats avec Checkout ;

- Mes centres d’intérêt avec l’historique de mes recherches ;

- Mes déplacements avec Latitude ;

- Mes loisirs (les programmes TV que je regarde) avec Google TV ;

- Mes lieux de vacances avec Picasa…

Et ce n’est qu’un début, car avec la sémantisation progressive du web, le moteur d’indexation pourra consolider toujours plus de données sur les internautes, mobinautes et même tvnautes. Les données seront donc la matière première à une nouvelle génération d’outils, services et prestations en rapport avec l’amélioration du quotidien de chacun. Des données qui seront l’objet d’une bataille acharnée pour en contrôler la possession, la collecte ou l’exploitation.

J’anticipe donc un web, dominé par les contenus et données, où Google jouera un rôle prépondérant. Facebook ou Twitter peuvent-ils prétendre à un rôle important dans ce tableau ? J’en doute car il faut des moyens considérables et surtout des appuis industriels et politiques, tout ce qui leur fait défaut actuellement. Longue vie au couple royal !

—

Billet initialement publié chez Fred Cavazza ; image Loguy /-)

Consultez nos articles sur les données et le datajournalisme, dont nos productions en la matière, et l’opendata

Laisser un commentaire